深度学习-4

回归和分类,softmax回归

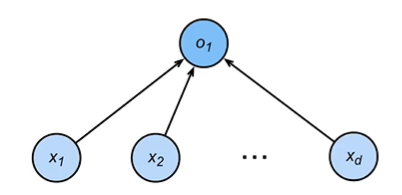

- 回归:估计一个连续值

- 单连续数值输出

- 自然区间R

- 跟真实值的区别作为损失

- 分类:预测一个离散类别

- 通常多个输出

- 输出i是预测为第i类的置信度

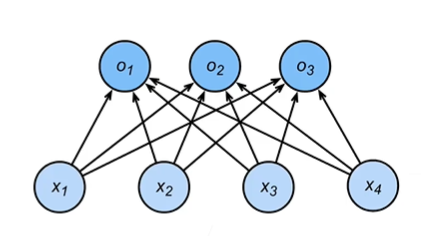

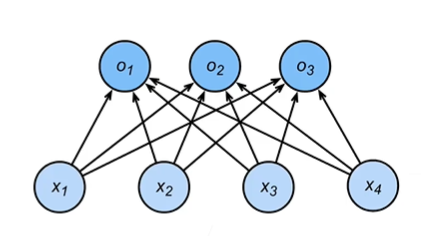

- 从回归到多类分类

- 均方损失

- 对类别进行一位有效编码

- \(y = [y_1, y_2, y_3, \ldots, y_n]^T\)

- \(y_i = \begin{cases} 1, & if\quad i = y \\0, & otherwise\end{cases}\)

- 使用均方损失训练

- 最大值作为预测

- \(\hat{y} = argmax{o_i}\)

- 需要更置信的识别正确类

- 对类别进行一位有效编码

- 校验比例

- 输出匹配概率(非负,和为1)

- \(\hat{y} = softmax(o)\)

- \(\hat{y_i} = \frac{exp(o_i)}{\sum_{k} exp(o_k)}\)

- 概率\(y和\hat{y}\)的区别作为损失

- 交叉熵

- 常用来衡量两个概率的区别

- \(H(p, q) = \sum_i - p_ilog(q_i)\)

- 将它作为损失

- \(l(y, \hat{y}) = - \sum_i y_ilog(\hat{y_i})\) = \(-log\hat{y}_y\)

- 其梯度是真实概率和预测概率的区别

- \(\partial_{o_i}l(y, \hat{y}) = softmax(o)_i - y_i\)

- 常用来衡量两个概率的区别

- 输出匹配概率(非负,和为1)

- 总结

- Softmax回归是一个多类分类模型

- 使用Softmax操作子得到每个类的预测置信度

- 使用交叉熵来测量预测和标号的区别作为损失函数

- 均方损失

损失函数

- L2 Loss

- \(l(y, y') = \frac{1}{2}(y - y')^2\)

- \(y:真实值,y':预测值\)

- L1 Loss

- \(l(y, y') = |y - y'|\)

- Huber's Robust Loss

- \(l(y, y') = \begin{cases} |y - y'| - \frac{1}{2} & if \quad |y - y'| > 1 \\ \frac{1}{2}(y - y')^2 & otherwise \end{cases}\)

图像分类数据集

- MNIST数据集是图像分类中广泛使用的数据集之一,过于简单

- 使用类似但更复杂的Fashion-MNIST数据集

1 | import torch |

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 Yeの博客!